Teknoloji devi Apple, çocuk güvenliği konusunda başlatacağı yeni dönem için bir açıklama daha yaptı. Yapmak zorunda kaldı.

Apple, çocuk güvenliğini artırmak adına hazırladığı yenilikler ile geçtiğimiz günlerde gerçekten çok büyük ses getirdi. Kısaca hatırlamak adına kısa süre önce uzmanlar ile ortaklaşa geliştirilen üç yeni özellik karşımıza çıktı.

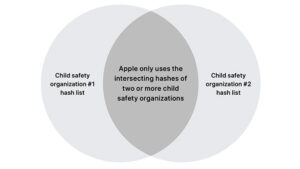

Bilmeyenler için iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey ile birlikte artık yerleşik mesajlar uygulaması makine öğrenmeyi kullanarak çocuklara gelen kötü (Çıplak fotoğraflar vb.) medya içeriklerini gizleyebilecek.

Yeni altyapıda en önemli detay ise Child Sexual Abuse Material (CSAM) olarak geçen, çocuğu bir cinsel obje olarak gösteren içeriklerin yayılmasını azaltma planı oldu. Çünkü teknoloji devi bunun için iOS 15 ve iPadOS 15 ile beraber cihaz temelli fotoğraf taraması yapmaya başlayacaklarını duyurdu.

Bu fotoğraf taraması, özel bir “hash” veri tabanı ile eğitilen algoritma temelinde işleyecek ve çocuk istismarı içeren fotoğraflar direkt olarak iPhone ve iPad’ler içerisinde ya da iCloud yedeklerinde tespit edilecek.

Bu fotoğrafları barındıran veya yayan kişiler daha sonra yetkili birimlere bildirilecek ve yakalanması için gerekli adımlar atılacak. Bir kişi suçlanmadan önce sistemin tespit ettiği fotoğraflar insan gözetmenler tarafından kontrol edilecek.

Resmi açıklamaya göre bu özellik kapatılabilecek. Apple’a göre fotoğraflar için iCloud yedeğini kapatmak, tarama sistemini cihaz özelinde de kapatacak.

İLGİNİZİ ÇEKEBİLİR

Apple, çocuk güvenliği konusunda tepki çekiyor

Türkiye’de açılıp açıklamayacağı halen bilinmeyen sistem, daha önce de hep aktardığımız üzere birçok kişiyi endişelendiriyor. Hemen herkes, devletlerin CSAM harici içerikler için de gizli fotoğraf / sistem taraması isteyeceğini düşünüyor. Apple ise harici istekleri kesinlikle kabul etmeyeceğini aktarıyor.

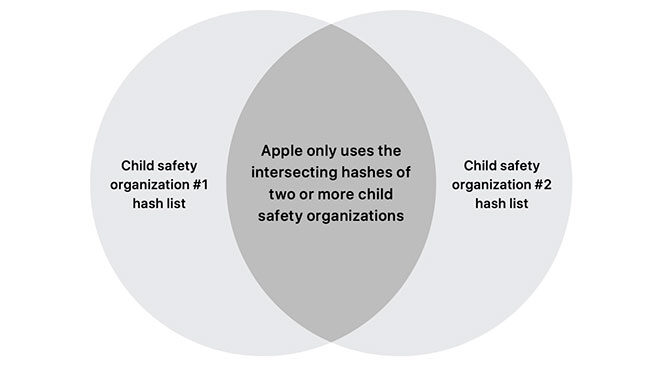

Hatta teknoloji devi artan tepkiler nedeniyle bu konuda bir açıklama daha yapmak zorunda kaldı. Apple, yeni sistemde CSAM için birden fazla ülkeden gelen ortak hash verilerinin kullanılacağını belirtti. Bu sayede bir devletin CSAM veritabanına “siyasi casusluk gibi başka amaçlar için” özel veri eklemesi zorlaşacak.

Bunu en baştan açıklamayarak bir hata yapan ve bunu da kabul eden firma, buna ek olarak sistemin “inceleme başlatılması” özelinde 30 fotoğraf üzerinde çalışacağını da aktardı. Yani bir kişi incelemeye alınmadan önce cihazında çocuk istismarıyla alakalı en az 30 adet fotoğrafın olması gerekecek.

Çocuk pornosu vb. gibi içerikleri telefonunda barındıran kişiler, yukarıda da dediğimiz gibi özel bir ekip tarafından kontrol edilecek. İnsan kontrolü ile süreç hatasız şekilde ilerletilecek. Bu ekip çok kötü fotoğraflara maruz kalacak ancak bu sayede binlerce çocuğun hayatı kurtulabilecek.