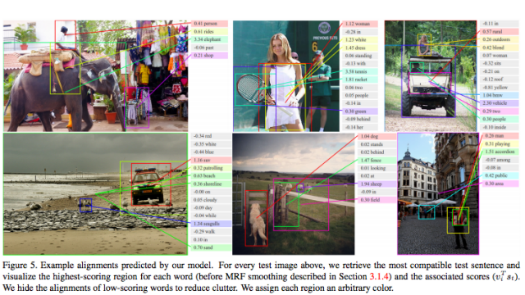

Öyle ki Google ve Stanford Üniversitesi‘nin ortaklaşa yürüttüğü proje kapsamında bilgisayarların görselleri “Çimde koşan iki köpek” gibi kalıplarla daha detaylı şekilde betimlemeleri sağlandı.

Görüntü algılama ve eşleştirme alanına yönelik mevcut uygulamalar uzun süredir çeşitli amaçlarla kullanılıyor. Fakat internet üzerindeki milyarlarca fotoğraf göz önüne alındığında aradığımız içeriği bilgisayara cümle ile tarif etmek düşündüğümüz kadar kolay olmuyor. Genel itibariyle hayli karışık bir yapıya sahip insan beynini makinelere daha iyi öğretebilmek için bağımsız çalışma yürüten Google ve Stanford Üniversitesi, görüntü algılama alanında bir üst seviyeye geçmeyi başardı.

Nöral ağları taklit edebilen Convolutional Neural Network ve Recurrent Neural Network gibi uygulamaları birbirlerine entegre eden araştırmacılar, kurulan yeni sistemi görseli tanıma ve insan diline uyarlama şeklinde iki bölüme ayırdılar. Karmaşık bir fotoğraftaki ögenin tek başına ve diğer ögelerle nasıl bir bağlantı içerisinde olduğunu anlama üzerine odaklanan araştırma, makinelerin taradıkları içerikleri “Bir grup genç insan frizbi oynuyor” ya da “Pembeli küçük kız baloncuk üflüyor” şeklinde insanın kurabileceği cümle formatına çevirebilmesi sağlandı.

Gelecekte görselleri “kedi, tenis, otomobil” gibi kelimelerle değil “sahilde koşan kedi, tenis oynayan kadın, otoparkta bulunan sarı otomobil” tarzında kalıplarla arayabilmemizi sağlayacak olan proje, diğer taraftan makinelerin algıladıkları nesneleri insan diline çevirmesini mümkün hale getiriyor. Şimdilik emekleme aşamasındaki araştırmanın eski nesil yöntemlere nazaran iki kat başarı sağladığı, bu sayede makine ve insan iletişiminin gelecekte çok daha kolaylaşacağı belirtiliyor.