Ekran kartı devi Nvidia, “yazılanları video” haline getiren yapay zekâ sistemi ile gündemde yer alıyor. Bu tarafa büyük ilerleme elde edildi.

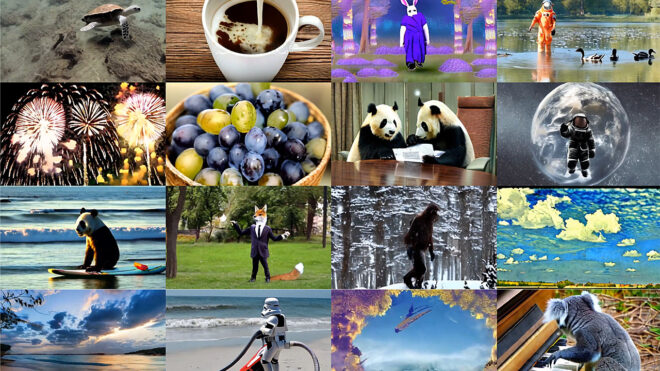

Bu aralar teknoloji dünyasının en büyük gündem konusu yapay zekâ oluyor. Yeni nesil “üretken” yapıdaki sistemler hem teknik hem de görsel olarak yeni kapıları aralıyor, bunlar arasında video tarafı da yer alıyor. Bu konuda aktif olarak çalışmalar yapan büyük isimlerden Nvidia, Latent Diffusion Model (LDM) temelli sistemiyle yazılanları şimdiye kadar gördüklerimizden çok daha iyi şekilde video haline getirebiliyor. Halen fotoğraf tarafındaki üretken yapay zekâ sistemlerinin sağladığı kaliteye (Örneğin MidJourney) ulaşılmış değil ancak hemen aşağıdaki örnekler gelecek için inanılmaz bir potansiyel ortaya koyuyor. IEEE Conference on Computer Vision and Pattern Recognition (CVPR) 2023 kapsamında sergilenen altyapı, çok sayıdaki fotoğraf ile videonun kullanıldığı büyük veri tabanları kullanıyor, bunları analiz eden sistemle şimdilik 1280×2048 piksel videolar oluşturulabiliyor. Elbette üzerinde çalışmalar sürecek sistem, gelecekte gerçek anlamda kullanıma girebilir ve video üretim sürecini temelli olarak değiştirebilir. Yakın gelecekte yapay zekâ tarafından üretilen videoları ayırt etmek imkânsız hale gelebilir.

🤯This is bonkers! Nothing in this video is real, it's all #AI generated by NVIDIA team using their Video LDMs!

This is a Specific Driving Scenario Simulation by training a bounding box-conditioned image-only LDM

And more in thread 🧵 pic.twitter.com/sQIPLE6x7H

— Min Choi (@minchoi) April 20, 2023

NVIDIA announces model for high-resolution text to video generation. It can generate videos with resolution up to 1280 x 2048. pic.twitter.com/waRXCQFWfa

— bleedingedge.ai (@bleedingedgeai) April 19, 2023

📣 NVIDIA released text-to-video research

"Align your Latents:

High-Resolution Video Synthesis with Latent Diffusion Models""Only 2.7B of these parameters are trained on videos. This means that our models are significantly smaller than those of several concurrent works.… pic.twitter.com/z868xAkwyT

— 𝚉𝚊𝚎𝚜𝚊𝚛 🎬 𝚊𝚒𝚏𝚒𝚕𝚖𝚜.𝚊𝚒 (@zaesarius) April 19, 2023

NVIDIA published a new Text-To-Video method this week which is able to build upon existing pre-trained Latent Diffusion Models like #StableDiffusion 👀

— Dreaming Tulpa 🥓👑 (@dreamingtulpa) April 20, 2023

"Align your Latents: High-Resolution Video Synthesis with Latent Diffusion Models" from NVIDIA Some very high-resolution, temporally-coherent text-to-video output from this model, which is fine-tuned on video sequences (with a temporally-aware upscaler). pic.twitter.com/LEjTohe39k

— Ben Ferns (@ben_ferns) April 19, 2023

İLGİNİZİ ÇEKEBİLİR

Bu konuda geçtiğimiz ay çok ses getiren içerik ise aşağıda izleyebileceğiniz Will Smith videosu olmuş, bu video hem komik ve hem de ürkütücü bulunmuştu. Bu videoda Smith’in spagetti yemesi inanılmaz garip bir şekilde simüle ediliyor, video spesifik olarak “Chaindrop” adlı Reddit kullanıcısından geliyor. Aktarıldığı kadarıyla 20 saniyelik aşağıdaki video için birbirinden bağımsız olarak oluşturulmuş 10 adet iki saniyelik bölüm bir araya getirilmiş. Her bir bölüm simüle edilmiş Will Smith’in açgözlülükle spagetti yemesini farklı açılarda gözler önüne seriyor, sürecin arkasında geliştirme aşamasında olan bir altyapı bulunuyor.

Videonun Alibaba’nın bir araştırma bölümü olan DAMO Vision Intelligence Lab tarafından hazırlanan ModelScope adlı yapay zekâ aracı üzerinde hazırlandığı aktarılıyor. ModelScope, “LAION5B, ImageNet ve Webvid” gibi veri tabanlarındaki milyonlarca fotoğraf ve binlerce videoyu analiz ederek, yazılan metinlerden videolar oluşturmak üzere eğitilmiş bir “text2video” modelini temel alıyor. Bu sistem Shutterstock’tan gelen videoları dahi analiz ediyor, bu yüzden paylaşılan videoda Shutterstock’un koruma amaçlı logosu da görünüyor. Birçok yapay zekâ sistemi bu logoları halen tam olarak ortadan kaldıramıyor, bu logolar yüzünden dava edilen firmalar bulunuyor.